Robots.txt Oluşturma ve Yapılandırma

Robots.txt dosyası arama motorlarının bir siteyi tararken takip ettikleri yönergeleri içerir. Siteye gelen arama motoru tarayıcısı bu dosyanın içerisinde yer alan yönlendirmelerden yararlanarak siteyi nasıl tarayacağını belirler. Belirli kategorilerin arama motorlarına eklenmesi istenmezse robots.txt dosyasında bunu belirtecek bir bilgi girilerek bu kolayca sağlanabilir.

Arama motorlarının belirli site içeriklerini taramasını ve dizine eklemesini engellemek istiyorsanız robots.txt dosyasını sitenin ana kök dizinine eklemeniz gerekmektedir. Örneğin, sitenizde yer alan PDF veya DOC dosyalarının dizine eklenmesini istemiyorsanız robots.txt dosyasına ilgili kuralları yazarak buna engel olabilirsiniz.

En önemli arama motorları burada belirttiğiniz kurallara uymayı kabul edebilirler ama bu kurallar bir tür zorunluluk değildir. Yeni gelişen bir arama motoru veya amacı kötü amaçlı girişimler olan arama motorları veya yazılımlar burada belirtilen kuralları es geçerek sitenizi tarayabilirler. Süper üçlü Google, Bing ve Yandex bu kurallara uyan standartlara sahip olduğu için gerektiğinde robots.txt dosyasını yapılandırmayı tercih edebilirsiniz.

Bu yazıda öncelikle robots.txt dosyasının nasıl oluşturulacağına ve ardından sitenizde hangi içerik türlerini robots.txt dosyasında engellemeniz gerektiğine değinecektir. Bu sayede robots.txt dosyası üzerinde dilediğiniz gibi düzenleme yapabilir hale gelebileceksiniz.

Robots.txt Temel Kurallar

Robots.txt dosyası birkaç saniye içerisinde oluşturulabilen bir dosyadır. Yapmanız gereken yeni bir not defteri oluşturmak ve onu robots.txt olarak kaydetmektir. Daha sonra bu dosyayı sitenizin bulunduğu sunucunun Root dizinine göndermelisiniz. Tabi gönderme işlemini yapmadan önce içerisine belirli kurallar eklemeyi düşünebilirsiniz.

Bu dosya için bir dosya izin değeri girmeniz gerektiğinde ise genel olarak tercih edilen değer 664 şeklindedir. Hosting hizmeti veren birçok yer bu dosyayı yükler yüklemez onun için gerekli olan dosya izni değerini otomatik olarak belirler. Her ne kadar robots.txt dosyasını elle düzenlemek kolay olsa bile bu işi WordPress üzerinde bir eklenti kullanarak epey kolaylaştırabilirsiniz. Kullanacağınız eklentinin doğrudan WordPress yönetici paneli üzerinden robots.txt dosyasını düzenlemeye izin vermesine dikkat etmeniz yeterli olacaktır.

Bir robots.txt dosyası oluşturup sitenin Root dizinine attıktan sonra arama motorları orada yer alan standartları inceleyerek sitenizi taramaya başlayacaktır. Arama motorları sitenizi her taradığında bu dosyadaki standartlara uyum sağlamaya çaba gösterecektir.

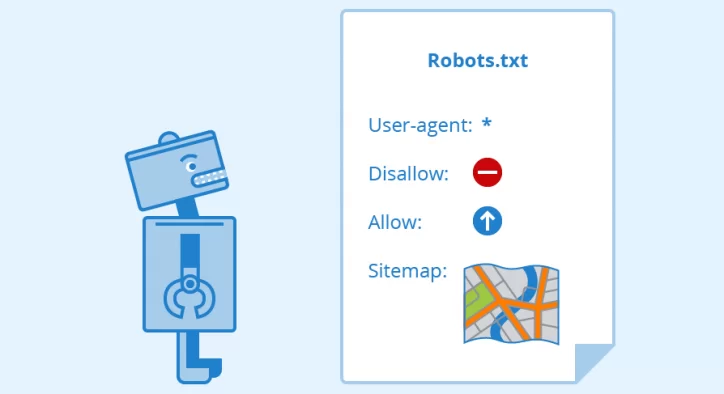

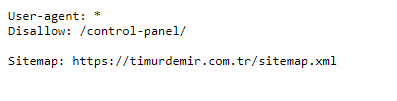

Robots.txt dosyası oluşturduğunuzda veya oluştururken bilmeniz gereken belirli standart kurallar vardır. Bu kurallar User-agent ve Disallow direktiflerinden oluşur. Basit bir biçimde söz etmek gerekirse User-agent, kuralların geçerli olduğu arama motorunu belirlemek için kullanacağınız direktif durumundadır. Genelde burada * kullanılır çünkü bu işaret kuralların tüm arama motorları için geçerli olduğunu ifade eder.

Diğer taraftan Disallow ise arama motorlarına sitede yer alan belirli sayfanın veya dosyanın dizine eklenmemesi gerektiği direktifini verir. Disallow direktifinden sonra / getirilmesi sitenin tamamen dizine eklenmesine engel olur, diğer taraftan bu kısım boş bırakılırsa arama motorları sitenin tamamını eksiksiz bir biçimde dizine ekleyebilir.

Robots.txt Standart Olmayan Kurallar

User-agent ve Disallow direktifleri her arama motoru tarafından desteklenir. Bunlar dışında kalan ve genel olarak standart olmayan kurallar olarak belirtilen çeşitli direktifler bulunmaktadır. Bu direktifler tüm arama motorları tarafından dikkate alınmadığı için bunlara standart olmayan kurallar denmiştir.

Allow direktifi bir arama motoruna belirli sayfanın veya dosyanın dizine eklenebileceği bilgisini verir. Sitemap direktifi sitenize ait site haritasının hangi konumda olduğunu belirtmenizi sağlar. Crawl-delay direktifi her tarama isteği arasındaki gecikme süresini belirlemenize yardımcı olur. Host ise belirli yönlendirme bağlantıları kullanmanız durumunda tercih ettiğiniz ana alan adı bilgisini arama motoru tarayıcısına iletmenizi sağlar.

Bu direktiflere her zaman ihtiyaç duymayabilirsiniz ama kullanmanız gerektiğinde oldukça işe yarayabilirler. Yine de standart olmayan kurallar arasında yer aldıkları için bu kurallara her arama motorunun uyum sağlamasını beklememelisiniz.

Gelişmiş Robots.txt Yapılandırmaları

Gelişmiş robots.txt yapılandırmaları var olan standart kurallar takip edilerek oluşturulmuş gelişmiş tekniklerdir. Örneğin Disallow direktifini belirli bir kelimeyle başlayan görsellerin taramaya dahil edilmemesi için kullanabilirsiniz. Disallow: /images/td*.jpg olarak yazacağınız bir direktif ilgili dizinde yer alan ve td1.jpg, td3.jpg ve td5.jpg gibi tüm görselleri kapsayacaktır. * işareti bir joker gibi her noktada kullanılabilecek özel bir işarettir.

Benzer kuralı diğer dosyalar için de kullanabilirsiniz. Örneğin sitenize yüklediğiniz tüm PDF dosyalarının taramaya dahil edilmemesini istiyorsanız Disallow: /downloads/*.pdf kuralını uygulayabilirsiniz.

Belirtilen bu örneklerden yola çıkarak robots.txt dosyasının içerisine dilediğiniz kadar direktif ekleyebilirsiniz. Bunun için herhangi bir sınırlama yoktur ama bu dosyanın içerisinde ne kadar az direktif kullanırsanız arama motorlarının işini bir o kadar kolaylaştırmış olursunuz.

Robots.txt Dosyasının Maksimum Boyutu

Her ne kadar bu dosya içerisinde dilediğiniz kadar direktif eklenebileceğini belirtmiş olsam bile bu konuda kullanılan global bir kurala uyum sağlamanız gerekmektedir. Bir robots.txt dosyasının içerisinde 200 adetten fazla Disallow direktifi yer almamalıdır. Ayrıca bir robots.txt dosyasının içerisinde yer alan karakter sayısının 5000 karakteri geçmemesi önerilir.

Bu kurala uyum sağladığınız sürece hiçbir sıkıntı yaşamadan robots.txt dosyasını kullanmayı başarabilirsiniz. Ek olarak oluşturduğunuz robots.txt dosyasının boyutu mutlaka 500Kb değerinin üstüne çıkmamalıdır. Bunu harici bir standart olarak düşünebilirsiniz.

Son olarak, oluşturduğunuz robots.txt dosyasını Google Arama Konsolu üzerinden test edebilirsiniz. Bu test işlemi dosyada yer alan hataları size gösterebilir ve robots.txt dosyasının arzu ettiğiniz gibi çalıştığından emin olmanızı sağlayabilir. Test aşamasını da geçtikten sonra robots.txt dosyasını arzu ettiğiniz şekilde kullanmaya başlayabilirsiniz.